EU AI Act: trasformazione normativa per l'ecosistema nutrizionale intelligente

L'entrata in vigore del EU AI Act il 1° agosto 2024 segna un momento storico per la regolamentazione tecnologica globale. Questa legislazione rivoluzionaria non rappresenta semplicemente un nuovo set di regole, ma costituisce il fondamento per una trasformazione radicale del modo in cui l'intelligenza artificiale viene integrata nei sistemi alimentari e nutrizionali europei. L'impatto si estende dall'innovazione tecnologica alla protezione dei consumatori, dalla competitività industriale all'eccellenza scientifica, delineando un futuro in cui la tecnologia AI serve l'umanità nel rispetto dei valori europei di trasparenza, responsabilità e sostenibilità.

Alessandro Drago

Il quadro normativo: un'architettura di compliance per l'era digitale

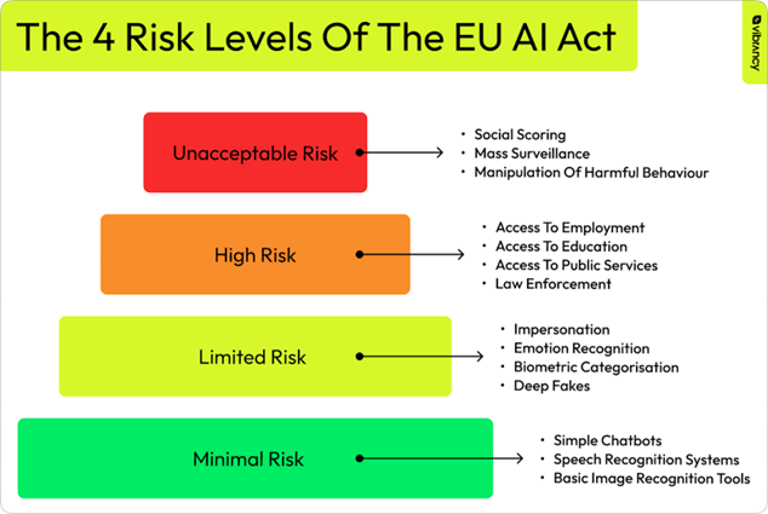

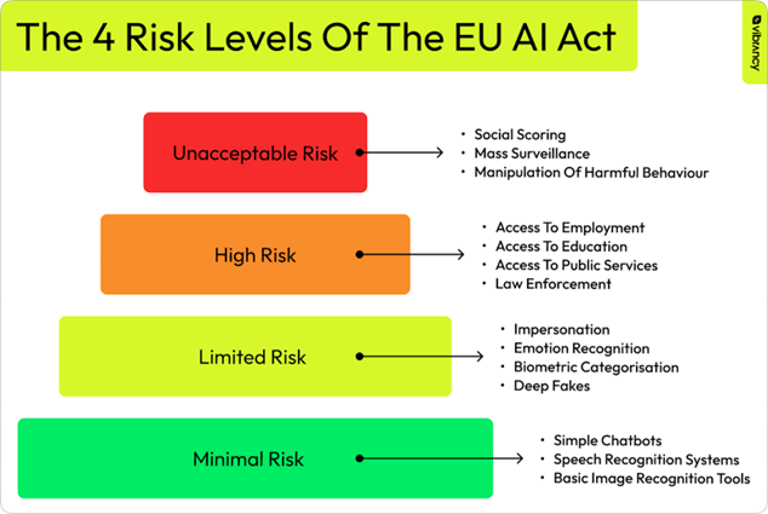

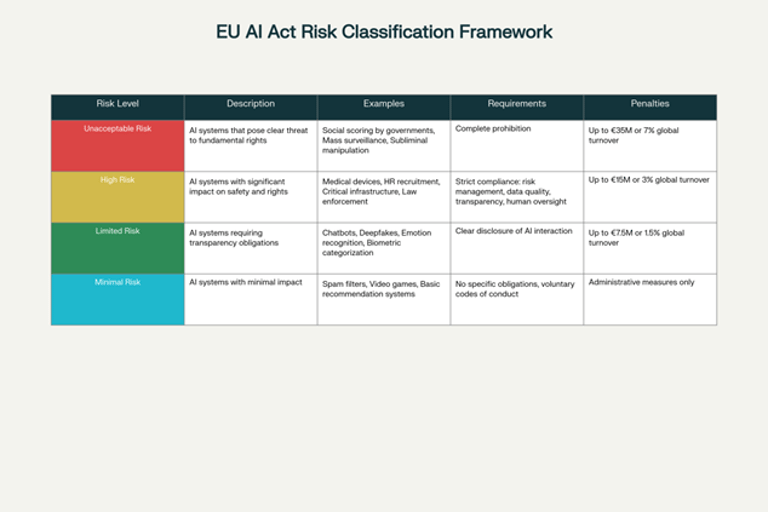

EU AI Act rappresenta la prima legislazione completa al mondo sull'intelligenza artificiale, introducendo un approccio innovativo basato sul rischio che classifica i sistemi AI in quattro categorie principali. Questa struttura normativa non è meramente punitiva, ma è progettata per favorire l'innovazione responsabile creando un ambiente di fiducia per consumatori, imprese e istituzioni.

La classificazione del rischio e le implicazioni settoriali

Il sistema di classificazione basato sul rischio dell'EU AI Act crea un framework graduale che riconosce la diversità delle applicazioni AI nel settore alimentare e nutrizionale. I sistemi a rischio minimo, che includono la maggior parte delle applicazioni di filtraggio e giochi abilitati dall'AI, non comportano obblighi specifici ma possono volontariamente adottare codici di condotta aggiuntivi. Questi sistemi rappresentano la base dell'ecosistema AI, fornendo funzionalità di supporto senza influenzare direttamente le decisioni critiche dei consumatori.

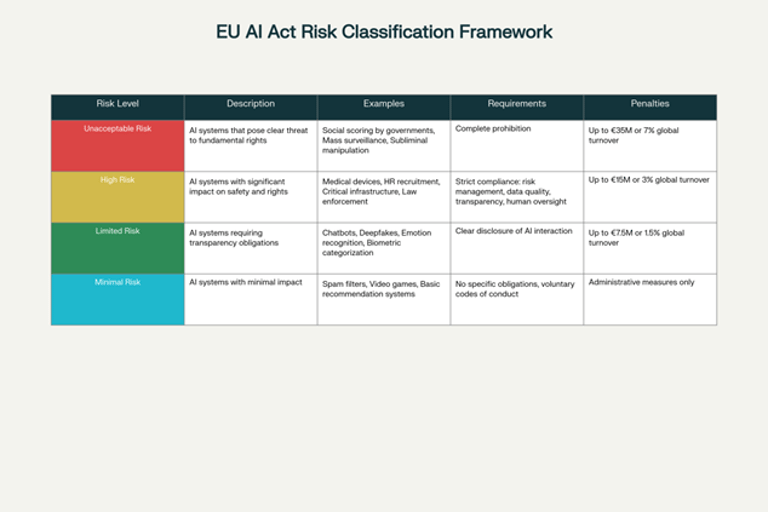

Framework di classificazione del rischio AI secondo EU AI Act

I sistemi a rischio di trasparenza specifico, come i chatbot nutrizionali o i sistemi di raccomandazione alimentare, devono informare chiaramente gli utenti della loro natura artificiale. Questa categoria è particolarmente rilevante per l'industria nutrizionale, dove molte applicazioni consumer-facing utilizzano AI per fornire consigli personalizzati. La trasparenza richiesta non è solo una questione di compliance, ma diventa un elemento di differenziazione competitiva e costruzione della fiducia.

I sistemi ad alto rischio includono molte applicazioni sanitarie e nutrizionali che possono influenzare direttamente le decisioni sanitarie dei consumatori. Questi sistemi devono rispettare requisiti rigorosi inclusi sistemi di mitigazione del rischio, alta qualità dei dataset, informazioni chiare per gli utenti e supervisione umana. Per l'industria della nutrizione personalizzata, questo significa implementare protocolli rigorosi di validazione scientifica e garantire che le raccomandazioni AI siano sempre supportate da evidenze solide.

I sistemi a rischio inaccettabile, come i sistemi di "punteggio sociale", sono completamente vietati. Sebbene meno direttamente rilevanti per il settore nutrizionale, questi divieti stabiliscono principi etici chiari che informano lo sviluppo responsabile di tutte le applicazioni AI.

L'architettura di governance: provider e deployer

L'EU AI Act introduce una distinzione fondamentale tra provider e deployer di sistemi AI, ciascuno con obblighi specifici che riflettono il loro ruolo nella catena del valore AI. Questa divisione è particolarmente importante nell'ecosistema nutrizionale, dove spesso abbiamo aziende tecnologiche che sviluppano piattaforme AI generiche e aziende alimentari o di supplementi che le implementano per i loro clienti.

I provider sono responsabili della progettazione e sviluppo dei sistemi AI, inclusa l'implementazione di un Sistema di Gestione della Qualità AI che unifica documentazione, valutazioni di conformità, log automatizzati, azioni correttive, monitoraggio post-commercializzazione e audit interni ed esterni. Per i provider di tecnologie nutrizionali AI, questo significa stabilire processi rigorosi di sviluppo che integrano considerazioni scientifiche, etiche e tecniche fin dalle prime fasi di progettazione.

I deployer, spesso aziende nutrizionali che utilizzano soluzioni AI sviluppate da terzi, devono assicurare livelli adeguati di alfabetizzazione AI del loro staff, implementare misure tecniche e organizzative appropriate per garantire l'uso corretto del sistema, gestire la qualità dei dati in input e sospendere l'operazione se il sistema non funziona come previsto. Questa responsabilità distribuita crea un ecosistema di accountability che rafforza la sicurezza e l'efficacia dei sistemi AI lungo l'intera catena del valore.

La timeline di implementazione: una roadmap strategica

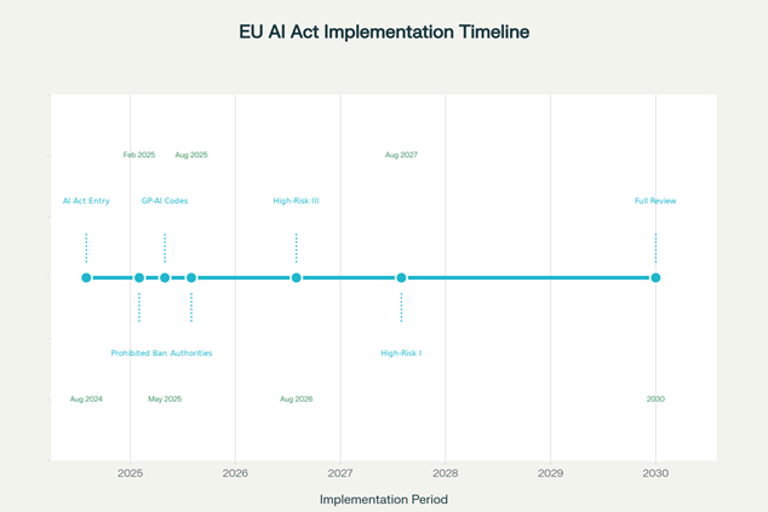

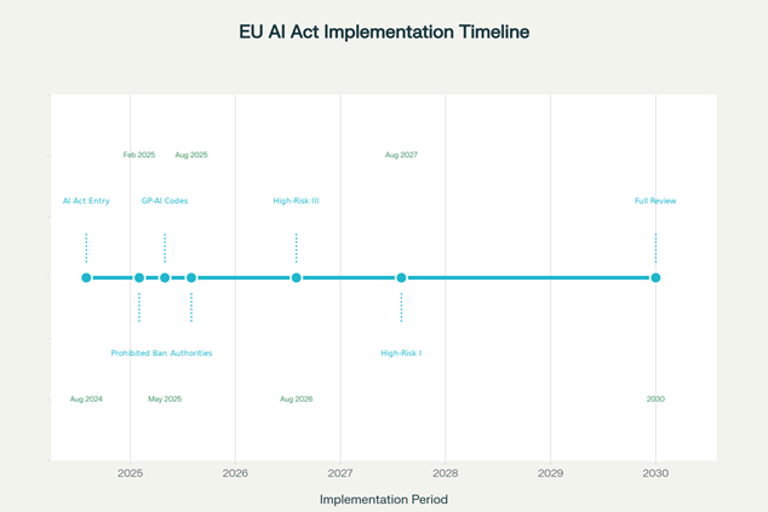

L'implementazione del EU AI Act segue una timeline scaglionata che riconosce la complessità dell'adattamento industriale e tecnologico. Questa approccio graduale permette alle organizzazioni di pianificare strategicamente i loro investimenti in compliance e di trasformare gli obblighi normativi in opportunità competitive.

La prima fase, già in vigore, riguarda i divieti sui sistemi AI a rischio inaccettabile. Sebbene questi divieti non influenzino direttamente la maggior parte delle applicazioni nutrizionali, stabiliscono principi etici importanti che informano tutto lo sviluppo AI successivo.

Entro febbraio 2025, le aziende devono garantire la compliance per tutti i sistemi vietati e iniziare la preparazione per le fasi successive. Questo periodo è cruciale per le organizzazioni nutrizionali per valutare i loro sistemi esistenti e identificare quali potrebbero richiedere modifiche per garantire compliance futura.

La seconda fase critica arriva ad agosto 2026, quando si applicano gli obblighi per i sistemi AI ad alto rischio specificatamente elencati nell'Annex III. Questa categoria include sistemi utilizzati in settori come biometria, infrastrutture critiche, educazione, occupazione, accesso a servizi pubblici essenziali, forze dell'ordine, immigrazione e amministrazione della giustizia. Mentre non tutti questi settori sono direttamente rilevanti per la nutrizione, molti sistemi nutrizionali AI potrebbero essere classificati come ad alto rischio se influenzano significativamente la salute dei consumatori.

La fase finale, ad agosto 2027, estende gli obblighi ai sistemi AI dell'Annex I e ai componenti di sicurezza di prodotti esistenti. Questa è probabilmente la fase più rilevante per l'industria nutrizionale, poiché molti dispositivi e applicazioni nutrizionali potrebbero essere classificati come componenti di sicurezza di sistemi più ampi.

La sistema sanzionatorio: deterrenza ed enforcement

Il framework sanzionatorio del EU AI Act è strutturato su tre livelli progressivi che riflettono la gravità delle violazioni e creano incentivi potenti per la compliance proattiva. Per l'industria nutrizionale, comprendere questo sistema è essenziale per valutare i rischi e pianificare investimenti appropriati in compliance.

Le sanzioni più severe, fino a 35 milioni di euro o fino al 7% del fatturato mondiale annuo, sono imposte per l'uso di sistemi AI vietati. Sebbene pochi sistemi nutrizionali AI rischino di rientrare in questa categoria, le potenziali conseguenze sono così severe da richiedere particolare attenzione nella progettazione di sistemi.

Il secondo livello di sanzioni, fino a 15 milioni di euro o fino al 3% del fatturato mondiale, si applica per non conformità con obblighi specifici di provider, deployer e altri operatori. Questo livello è particolarmente rilevante per l'industria nutrizionale, poiché molti sistemi di raccomandazione personalizzata potrebbero essere classificati come ad alto rischio.

Il terzo livello, fino a 7,5 milioni di euro o 1% del fatturato mondiale, riguarda la fornitura di informazioni errate o incomplete alle autorità competenti. Questo enfatizza l'importanza della trasparenza e dell'accuratezza nella documentazione e comunicazione con i regolatori.

l'ecosistema AI per la sicurezza alimentare: una trasformazione sistemica

Il moderno panorama della sicurezza alimentare richiede un'integrazione senza precedenti di tecnologia, dati e compliance normativa. L'emergere di un ecosistema AI per la sicurezza alimentare rappresenta una trasformazione sistemica che tocca ogni aspetto della catena alimentare, dalla produzione alla distribuzione, dal monitoraggio alla risposta alle crisi.

l'architettura tecnologica dell'integrazione

L'architettura tecnologica dell'ecosistema AI per la sicurezza alimentare si basa su tre componenti fondamentali che devono operare in armonia nel rispetto del framework regolatorio del EU AI Act. L'integrazione di dati multi-sorgente include sensori IoT distribuiti lungo la catena di approvvigionamento, dati meteorologici e ambientali, informazioni di laboratorio, dati di sorveglianza epidemiologica e intelligence di mercato.

L'AI orchestra questi flussi di dati diversi, identificando correlazioni e pattern che sarebbero impossibili da rilevare manualmente. Tuttavia, nel contesto del EU AI Act, questi sistemi devono garantire la qualità e rappresentatività dei dati, implementare meccanismi di trasparenza e mantenere supervisione umana appropriata.

L'analisi predittiva in tempo reale utilizza algoritmi di Machine Learning avanzati per identificare rischi emergenti prima che si manifestino come crisi. Questi sistemi possono prevedere focolai di malattie foodborne, contaminazioni chimiche, problemi di qualità e interruzioni della supply chain con settimane o mesi di anticipo. La sfida nel contesto del EU AI Act è garantire che questi sistemi predittivi siano sufficientemente spiegabili e che le loro previsioni possano essere validate da esperti umani.

Blockchain e trasparenza della supply chain

L'integrazione della tecnologia blockchain con sistemi AI crea un livello di trasparenza e tracciabilità senza precedenti nella supply chain alimentare, perfettamente allineato con i requisiti di trasparenza dell'EU AI Act. La blockchain fornisce un registro immutabile delle transazioni e movimenti dei prodotti, mentre l'AI analizza questi dati per identificare anomalie e rischi.

Studi recenti dimostrano che i consumatori sono disposti a pagare un premium significativo per prodotti con tracciabilità blockchain-based, particolarmente per prodotti sensibili come le formule infantili. Questa willingness to pay riflette una crescente domanda di trasparenza che l'AI può aiutare a soddisfare mentre rispetta i requisiti normativi.

La combinazione di blockchain e AI permette la creazione di "digital twins" dei prodotti alimentari che seguono ogni prodotto dalla produzione al consumo. Questi digital twins forniscono una visibilità completa della storia del prodotto e permettono interventi rapidi in caso di problemi di sicurezza, creando al contempo la documentazione necessaria per dimostrare compliance con l'EU AI Act.

la sfida della fiducia e credibilità: costruire l'accettazione pubblica

L'adozione diffusa dell'AI nei sistemi alimentari dipende criticamente dalla fiducia pubblica, che deve essere costruita attraverso trasparenza, affidabilità e risultati dimostrabili. L'EU AI Act riconosce questa sfida e incorpora requisiti specifici progettati per costruire e mantenere la fiducia pubblica.

il paradosso della fiducia degli utilizzatori di integratori

Un fenomeno particolarmente interessante emerge dall'analisi della fiducia del consumatore nell'AI: gli utenti di integratori dimostrano una fiducia significativamente maggiore nella tecnologia AI rispetto ai non-utenti, con il 64% che vede l'AI positivamente versus solo il 40% dei non-utilizzatori. Questo divario suggerisce che l'industria degli integratori ha un'opportunità unica per guidare nell'adozione responsabile dell'AI.

Questa fiducia differenziale può essere attribuita a diversi fattori che l'industria deve comprendere e leveraggiare responsabilmente. Gli utenti di integratori tendono ad essere più informati sui temi di salute e nutrizione, più aperti a nuove tecnologie sanitarie e più orientati verso soluzioni personalizzate. Inoltre, molti utenti di integratori hanno già esperienza con raccomandazioni personalizzate basate su questionari o test, rendendo più naturale il passaggio a sistemi AI-powered.

Le aspettative di trasparenza e disclosure

La fiducia dei consumatori nell'AI viene accompagnata da aspettative elevate per trasparenza e accountability che si allineano perfettamente con i requisiti dell'EU AI Act. L'87% degli utenti di integratori vuole che il coinvolgimento dell'AI sia dichiarato sulle etichette dei prodotti, rispetto al 79% dei non-utenti. Questa domanda di disclosure riflette una comprensione sofisticata del ruolo dell'AI e un desiderio di consenso informato.

L'industria nutrizionale ha l'opportunità di superare i requisiti minimi dell'EU AI Act, creando standard di trasparenza che diventano un vantaggio competitivo. Questo può includere spiegazioni dettagliate di come funzionano i sistemi AI, quali dati utilizzano e come vengono prese le decisioni di raccomandazione.

La research mostra anche che quasi due terzi degli utenti di integratori sono disposti a permettere all'AI di analizzare il loro makeup genetico per raccomandazioni nutrizionali personalizzate, rappresentando quasi il doppio del tasso di accettazione dei non-utilizzatori. Questo indica un'apertura significativa verso applicazioni AI più invasive quando il beneficio percepito è alto e la trasparenza è garantita.

Opportunità di mercato e proiezioni di crescita: l'economia della nutrizione AI

Il business case per l'AI nella nutrizione personalizzata si rafforza continuamente, supportato da proiezioni di mercato che mostrano un potenziale di crescita eccezionale e da fattori demografici e tecnologici favorevoli. L'EU AI Act, anziché frenare questa crescita, può accelerarla creando un ambiente di maggiore fiducia e standardizzazione.

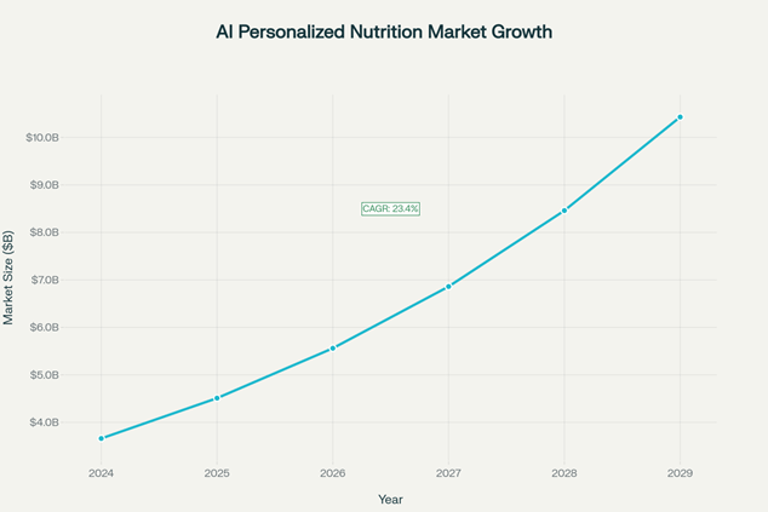

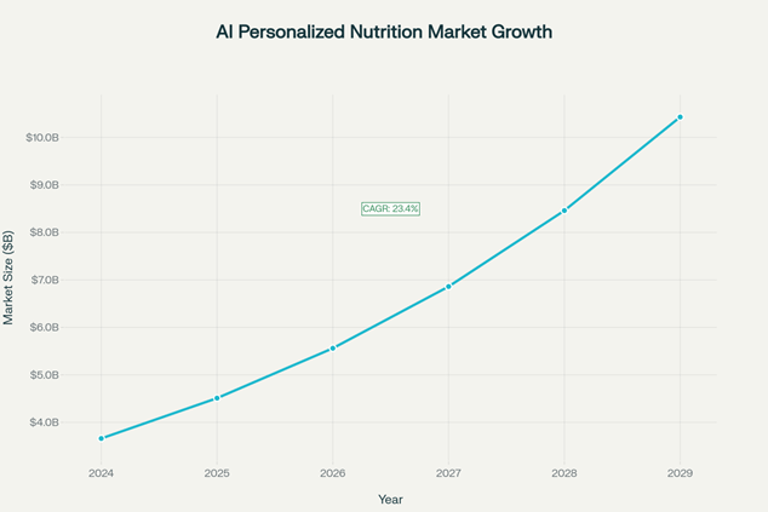

La dinamica di crescita del mercato

Il mercato globale dell'AI nella nutrizione personalizzata è proiettato a crescere da 3,66 miliardi di dollari nel 2024 a oltre 10,43 miliardi di dollari entro il 2029, con un tasso di crescita annuo composto del 23,4%. Questa crescita eccezionale riflette la convergenza di diversi trend tecnologici, demografici e sociali che l'EU AI Act è progettato per supportare e regolare.

I fattori trainanti includono l'aumento degli investimenti in health tech, l'invecchiamento della popolazione globale, l'aumento delle malattie legate allo stile di vita, l'utilizzo più ampio dell'AI per la medicina di precisione e l'aumento di condizioni croniche come diabete e obesità. Questi trend creano un mercato sempre più ricettivo a soluzioni nutrizionali personalizzate e basate su evidenze, esattamente il tipo di applicazioni che l'EU AI Act è progettato per rendere più sicure e affidabili.

L'impatto della regolamentazione sulla crescita

Contrariamente alle preoccupazioni iniziali, l'EU AI Act può accelerare la crescita del mercato creando un ambiente di maggiore fiducia e standardizzazione. La regolamentazione chiara riduce l'incertezza per gli investitori e le aziende, facilitando pianificazione e investimenti a lungo termine.

La compliance con l'EU AI Act può diventare un vantaggio competitivo per le aziende europee nei mercati globali, dove la "EU compliance" diventa sinonimo di qualità e affidabilità. Questo può portare a un effetto "Brussels Effect" dove gli standard europei diventano de facto standard globali, creando opportunità significative per le aziende che investono early in compliance.

Il vantaggio competitivo della compliance: ROI della responsabilità

Le organizzazioni che abbracciano proattivamente la convergenza di AI, regolamentazione e scienza nutrizionale non solo mitigano rischi ma creano vantaggi competitivi sostenibili che si traducono in performance finanziaria superiore.

Accelerazione del Time-to-Market

Le aziende che utilizzano strumenti di compliance guidati dall'AI riportano un ingresso 10 volte più veloce in nuovi mercati mantenendo piena aderenza regolatoria. Questa accelerazione deriva dalla capacità dell'AI di automatizzare processi di verifica compliance che tradizionalmente richiedevano settimane o mesi di lavoro manuale.

L'automazione include il controllo automatico delle formulazioni contro database regolatori, la generazione automatica di documentazione di compliance, la verifica automatica delle health claims e l'identificazione proattiva di potenziali problemi regolatori. Questi processi non solo accelerano il time-to-market ma riducono anche il rischio di errori umani che possono portare a costosi ritardi o sanzioni.

Le aziende leader stanno sviluppando "digital compliance engines" che integrano multiple fonti regolatorie e possono valutare la compliance di nuovi prodotti in tempo reale. Questi sistemi rappresentano un vantaggio competitivo significativo in mercati dove la velocità di innovazione è cruciale e dove la compliance è sempre più complessa.

Enhancement della fiducia del consumatore

La trasparenza e il rigore scientifico abilitati da sistemi AI compliant si traducono direttamente in maggiore fiducia del consumatore. Questo è particolarmente importante dato che l'87% degli utenti di supplementi supporta la dichiarazione obbligatoria di AI sulle etichette.

La fiducia del consumatore si traduce in multiple metriche di business positive, inclusi higher customer lifetime value, reduced customer acquisition costs, enhanced brand loyalty e premium pricing capability. Le aziende che investono in trasparenza AI vedono questi benefici amplificati nel tempo, creando cicli virtuosi di crescita sostenibile.

Conclusioni: l'imperativo dell'azione strategica

L'EU AI Act rappresenta più di una nuova regolamentazione: è un catalizzatore per una trasformazione fondamentale dell'industria nutrizionale verso maggiore responsabilità, trasparenza e efficacia. Le organizzazioni che comprendono questa dinamica e agiscono proattivamente non solo garantiranno compliance ma emergeranno come leader in un nuovo paradigma industriale.

La convergenza di AI, regolamentazione europea e innovazione nutrizionale crea opportunità senza precedenti per le aziende visionarie che sono disposte a investire nella costruzione di sistemi responsabili e trasparenti. Il futuro appartiene a coloro che possono navigare magistralmente l'intersezione di scienza, tecnologia e regolamentazione, creando soluzioni che servono sia gli imperativi di business che il bene pubblico.

#TrasformazioneAI #SicurezzaAlimentare #RegolazioneUE #InnovazioneScientifica #ScienzaRegolatoria #AIHumanCentric #EFSA #SaluteDigitale #PoliticheEvidenceBased #TecnologiaRegolamentare #AIinScienza #RegulatoryTech #RegolazioneIntelligente #InvazioneScientifica

Disclaimer: Tutti i diritti delle immagini e contenuti utilizzati appartengono ai rispettivi proprietari.

--------------------------------------------------------------------------

1. https://journals.aom.org/doi/10.5465/amr.2018.0072

4. https://www.aalpha.net/blog/human-ai-collaboration-augmenting-capabilities-with-agentic-platforms/

6. https://link.springer.com/10.1007/s00607-023-01181-x

8. https://pmc.ncbi.nlm.nih.gov/articles/PMC11826052/

9. https://pmc.ncbi.nlm.nih.gov/articles/PMC6582554/

10. https://pmc.ncbi.nlm.nih.gov/articles/PMC11624811/

11. https://www.nature.com/articles/s41562-024-02024-1

12. https://www.tandfonline.com/doi/pdf/10.1080/13600834.2021.1958860?needAccess=true

13. https://arxiv.org/pdf/2503.19159.pdf

14. https://www.jmir.org/2024/1/e50130

15. https://www.efsa.europa.eu/en/corporate-pubs/aiefsa

16. https://www.efsa.europa.eu/en/supporting/pub/en-7339

20. https://www.efsa.europa.eu/sites/default/files/2024-03/4-update-on-advisory-group-data.pdf

22. https://www.efsa.europa.eu/en/supporting/pub/en-8223

23. https://bmjopen.bmj.com/lookup/doi/10.1136/bmjopen-2023-072254

24. https://pmc.ncbi.nlm.nih.gov/articles/PMC10335470/

25. https://www.efsa.europa.eu/sites/default/files/event/mb100/Item 04 - doc1 - AAR2024 - mb250327-a2.pdf

26. https://www.distillersr.com/products/distillersr-systematic-review-software

27. https://www.distillersr.com/resources/updates/whats-new-in-distillersr-makeover-time

28. https://pmc.ncbi.nlm.nih.gov/articles/PMC7559198/

30. https://www.efsa.europa.eu/en/supporting/pub/en-9394

31. http://users.ics.forth.gr/~tzitzik/publications/Tzitzikas-2024-EFSA-Ontologies.pdf

32. https://ceur-ws.org/Vol-3415/paper-5.pdf

34. https://www.efsa.europa.eu/sites/default/files/2022-01/amp2325.pdf

35. https://www.efsa.europa.eu/sites/default/files/event/mb93/mb221215-a3.pdf

37. https://www.efsa.europa.eu/en/supporting/pub/en-8567

38. https://pmc.ncbi.nlm.nih.gov/articles/PMC11584592/

39. https://www.efsa.europa.eu/sites/default/files/event/2020/AF200401-p3.4_CH_MH.pdf

40. https://foodsafetyplatform.eu

41. https://pmc.ncbi.nlm.nih.gov/articles/PMC9749438/

42. https://euagenda.eu/publications/download/637218

43. https://science-council.food.gov.uk/Results and Discussion

44. https://www.efsa.europa.eu/en/supporting/pub/en-9654

45. https://dx.plos.org/10.1371/journal.pone.0303083

46. https://www.mdpi.com/1660-4601/18/23/12635/pdf

47. https://www.mdpi.com/2571-9394/6/4/46

48. https://www.efsa.europa.eu/sites/default/files/EFSA_Environmental_Scan_Report_2019.pdf

49. https://www.fao.org/food-safety/news/news-details/en/c/1748997/

50. https://international-animalhealth.com/wp-content/uploads/2024/10/FEED-AND-ADDITIVES.pdf

51. https://www.fao.org/food-safety/news/news-details/ru/c/1743810/

53. https://www.nature.com/articles/s41598-024-59616-0

54. https://www.semanticscholar.org/paper/be0cd07d1d590b7dc7475cd3bb9d01dbf1862db6

55. https://aja.journals.ekb.eg/article_452225.html

56. https://onlinelibrary.wiley.com/doi/10.1002/hfm.70022

57. https://al-kindipublishers.org/index.php/jcsts/article/view/8592

58. https://ieeexplore.ieee.org/document/10653012/

59. https://www.jippublication.com/index.php/jip/article/view/162

60. https://account.theoryandpractice.citizenscienceassociation.org/index.php/up-j-cstp/article/view/738

61. https://ijsrem.com/download/ai-driven-accounting-opportunities-challenges-and-the-road-ahead/

62. https://dx.plos.org/10.1371/journal.pone.0298037

63. https://onlinelibrary.wiley.com/doi/pdfdirect/10.1111/rego.12568

64. https://pmc.ncbi.nlm.nih.gov/articles/PMC11066064/

65. https://arxiv.org/pdf/2402.08466.pdf

66. http://arxiv.org/pdf/2503.02250.pdf

67. https://arxiv.org/html/2410.14353

68. http://arxiv.org/pdf/2403.00148.pdf

69. https://intuitionlabs.ai/articles/ai-future-regulatory-affairs-pharma

70. https://researchswinger.org/publications/aijobs25.pdf

71. https://pubsonline.informs.org/doi/10.1287/mnsc.2024.05684

72. https://www.sciencedirect.com/science/article/pii/S2452414X25000950

73. https://www.mdpi.com/1996-1944/17/21/5285

74. https://journals.sagepub.com/doi/10.1177/23259671221149403

75. https://revistes.ub.edu/index.php/der/article/view/41399

76. https://academic.oup.com/jamia/article/32/6/1071/8126534

77. https://link.springer.com/10.1007/s00217-024-04553-5

78. https://link.springer.com/10.1007/s42979-023-02583-6

79. https://josr-online.biomedcentral.com/articles/10.1186/s13018-024-05234-5

80. https://afju.springeropen.com/articles/10.1186/s12301-024-00464-9

81. https://www.mdpi.com/2305-6290/7/4/80

82. https://arxiv.org/ftp/arxiv/papers/2403/2403.08352.pdf

83. https://zenodo.org/record/8338404/files/RaischKrakowski_AMR_inpress.pdf

84. https://pmc.ncbi.nlm.nih.gov/articles/PMC4100748/

85. https://www.annualreviews.org/content/journals/10.1146/annurev-soc-090523-050708

Contatti

Seguimi su LinkedIn

Nutri-AI 2025 - Alessandro Drago. Tutti i diritti sono riservati

e-mail: info@nutri-ai.net