Implementazione dell'IA nella Comunicazione Scientifica Nutrizionale: Conformità Normativa e Buone Pratiche nei Contesti Lavorativi

L'IA rappresenta una trasformazione senza precedenti nel settore della comunicazione scientifica e della nutrizione, portando con sé opportunità straordinarie e responsabilità normative complesse. Nel panorama europeo, il quadro normativo che governa l'implementazione dell'IA nei contesti lavorativi del settore salute e benessere si articola attraverso quattro pilastri fondamentali: l'EU AI Act, la Regulation (EC) 1924/2006 sulle dichiarazioni nutrizionali e sulla salute, le linee guida dell'EFSA (European Food Safety Authority) e lo standard ISO/IEC 42001 per la gestione dei sistemi di IA.

Alessandro Drago

Un Nuovo Paradigma Normativo per l'IA nel Settore Alimentare

L'implementazione dell'Intelligenza Artificiale (IA) nella comunicazione scientifica e nutrizionale rappresenta una trasformazione epocale che sta ridefinendo le modalità operative, i processi decisionali e le strategie di comunicazione nel settore della salute e del benessere. Questa rivoluzione tecnologica porta con sé opportunità straordinarie in termini di efficienza operativa, accuratezza delle valutazioni scientifiche e personalizzazione delle raccomandazioni nutrizionali, ma genera simultaneamente responsabilità normative di notevole complessità che le organizzazioni devono affrontare con rigore metodologico e trasparenza operativa.

Nel contesto europeo, il quadro regolatorio che governa l'adozione e l'implementazione dell'IA nei contesti lavorativi del settore alimentare e nutrizionale si articola attraverso quattro pilastri normativi fondamentali, ciascuno dei quali stabilisce requisiti specifici e complementari: il Regolamento sull'Intelligenza Artificiale dell'Unione Europea (EU AI Act, Regolamento UE 2024/1689), entrato pienamente in vigore nell'agosto 2024 come primo framework normativo multinazionale comprensivo per l'IA; il Regolamento (CE) n. 1924/2006 del Parlamento Europeo e del Consiglio relativo alle indicazioni nutrizionali e sulla salute fornite sui prodotti alimentari, che costituisce la base normativa per qualsiasi comunicazione relativa alle proprietà salutistiche degli alimenti; le linee guida scientifiche e operative dell'Autorità Europea per la Sicurezza Alimentare (EFSA), che stabiliscono gli standard metodologici per la valutazione dell'evidenza scientifica; e lo standard internazionale ISO/IEC 42001:2023, che fornisce un framework sistematico per la gestione dei sistemi di intelligenza artificiale nelle organizzazioni.

Questo articolo si propone di fornire una guida tecnica e operativa, scientificamente fondata e verificabile, destinata alle organizzazioni che intendono implementare soluzioni di IA nella comunicazione scientifica nutrizionale, garantendo al contempo piena conformità normativa, trasparenza metodologica, accountability istituzionale e mantenimento della fiducia degli stakeholder in un ambiente regolatorio in rapida evoluzione.

Il Framework Normativo Europeo: Architettura Giuridica e Implicazioni Operative

L'EU AI Act: Regolazione Risk-Based e Classificazione dei Sistemi

Il Regolamento (UE) 2024/1689 del Parlamento Europeo e del Consiglio, comunemente denominato Artificial Intelligence Act, rappresenta la pietra angolare della regolamentazione europea in materia di intelligenza artificiale. Pubblicato nella Gazzetta Ufficiale dell'Unione Europea il 12 luglio 2024 ed entrato in vigore il 1° agosto 2024, questo framework normativo senza precedenti stabilisce regole armonizzate per lo sviluppo, l'immissione sul mercato e l'utilizzo di sistemi di IA nell'Unione Europea, seguendo un approccio basato sul rischio che bilancia innovazione tecnologica e protezione dei diritti fondamentali.

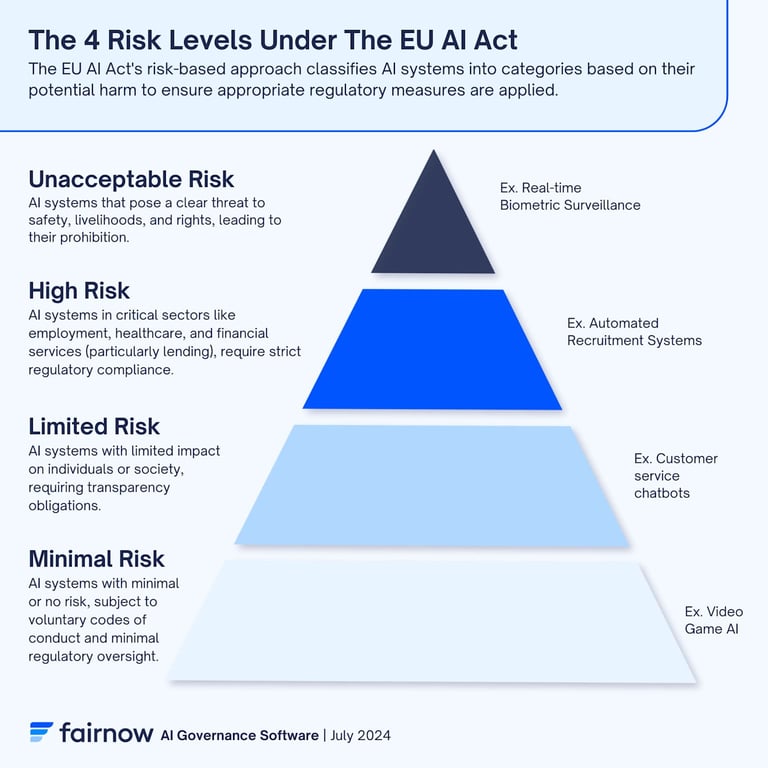

La caratteristica distintiva dell'EU AI Act è il suo approccio metodologico risk-based, che classifica i sistemi di IA secondo quattro categorie di rischio progressivamente crescenti, ciascuna soggetta a obblighi normativi proporzionali alla potenziale gravità delle conseguenze per la salute, la sicurezza e i diritti fondamentali delle persone. Questa tassonomia comprende: sistemi a rischio inaccettabile, categoricamente proibiti perché considerati incompatibili con i valori fondamentali dell'Unione Europea e potenzialmente lesivi dei diritti umani fondamentali; sistemi ad alto rischio (high-risk), definiti negli Allegati I e III del Regolamento, che hanno un impatto significativo su salute, sicurezza e diritti fondamentali e sono soggetti a obblighi stringenti di conformità; sistemi a rischio limitato o medio-basso, per i quali si applicano principalmente obblighi di trasparenza; e sistemi a rischio minimo, che non sono soggetti a particolari obblighi normativi data la loro natura benigna.

Per quanto concerne specificamente il settore della comunicazione scientifica nutrizionale, l'applicabilità della classificazione high-risk è particolarmente rilevante. La maggioranza dei sistemi di IA implementati in questo ambito ricade infatti nella categoria ad alto rischio per diverse ragioni tecniche e normative. In primo luogo, i sistemi che generano raccomandazioni nutrizionali personalizzate basate su profili individuali di salute, genetici o metabolici hanno un impatto diretto sulla salute umana e richiedono pertanto una supervisione umana qualificata (human oversight) come stabilito dall'Articolo 14 del Regolamento. In secondo luogo, i sistemi che effettuano valutazioni automatizzate di health claims o supportano processi decisionali relativi alla conformità normativa o all'autorizzazione di prodotti alimentari influenzano direttamente l'accuratezza informativa e la sicurezza dei consumatori, configurandosi come sistemi critici per la salute pubblica. In terzo luogo, i sistemi di IA utilizzati per l'analisi sistematica della letteratura scientifica a supporto di dossier EFSA per health claims, o per il rilevamento di frodi documentali, processano dati sensibili e supportano decisioni regolatorie con conseguenze economiche e di salute pubblica significative.

Il Regolamento stabilisce timeline di conformità stringenti che le organizzazioni devono rispettare. Il 2 febbraio 2025 segna l'inizio degli obblighi di trasparenza per i sistemi a rischio limitato, come previsto dall'Articolo 52 del Regolamento. Il 2 agosto 2026 rappresenta la deadline critica per la piena conformità dei sistemi ad alto rischio, come stabilito dall'Articolo 113, con tutti i requisiti degli Articoli 8-15 pienamente operativi. Infine, il 2 agosto 2027 è la scadenza ultima per la conformità dei sistemi ad alto rischio già integrati in prodotti regolamentati prima dell'entrata in vigore del Regolamento.

Regolamento (CE) 1924/2006: Foundation Normativa per le Health Claims

Il Regolamento (CE) n. 1924/2006 del Parlamento Europeo e del Consiglio del 20 dicembre 2006 relativo alle indicazioni nutrizionali e sulla salute fornite sui prodotti alimentari costituisce il pilastro fondamentale della regolamentazione europea in materia di comunicazione delle proprietà salutistiche degli alimenti. Questo framework normativo, consolidato da quasi due decenni di applicazione e da un'ampia giurisprudenza della Corte di Giustizia dell'Unione Europea, stabilisce criteri rigorosi per garantire che qualsiasi comunicazione relativa agli effetti benefici degli alimenti sulla salute sia scientificamente accurata, non ingannevole e verificabile.

I criteri fondamentali che il Regolamento impone per le health claims sono articolati e stringenti. In primo luogo, le dichiarazioni devono essere basate su prove scientifiche generalmente accettate dalla comunità scientifica internazionale e disponibili pubblicamente, come specificato nell'Articolo 6 del Regolamento. In secondo luogo, tutte le health claims devono essere sottoposte a una valutazione scientifica rigorosa condotta dall'EFSA attraverso il Panel on Nutrition, Novel Foods and Food Allergens (NDA), seguendo le procedure stabilite nell'Articolo 15-19 del Regolamento. In terzo luogo, le dichiarazioni autorizzate devono essere utilizzate esattamente secondo le formulazioni approvate e pubblicate nel Registro UE delle indicazioni nutrizionali e sulla salute, accessibile pubblicamente sulla piattaforma online della Commissione Europea. Infine, le health claims devono essere supportate da dati scientifici robusti, derivanti preferibilmente da studi clinici randomizzati controllati su popolazione umana, come specificato nelle linee guida EFSA sulla substantiation scientifica.

Le implicazioni di questo framework normativo per i sistemi di IA che operano nella comunicazione nutrizionale sono profonde e multidimensionali. Qualsiasi sistema di IA che generi, selezioni, validi o comunichi health claims deve essere progettato e validato per garantire tracciabilità scientifica completa, collegando ogni affermazione generata ai dati scientifici di supporto presenti nella letteratura peer-reviewed e verificabile. Il sistema deve inoltre incorporare meccanismi di conformità automatizzata che verifichino in tempo reale il rispetto delle formulazioni esatte autorizzate dall'EFSA e presenti nel Registro UE. È imprescindibile mantenere un audit trail documentale completo di ogni decisione algoritmica, della base scientifica utilizzata e del processo di validazione umana applicato. Infine, i sistemi devono essere progettati con meccanismi intrinseci di esclusione dei bias algoritmici per evitare sistematicamente che distorsioni nei dati di training o nelle logiche decisionali portino alla generazione di dichiarazioni non supportate scientificamente o potenzialmente ingannevoli per i consumatori.

Linee Guida EFSA: Eccellenza Scientifica e Human-Centric AI

L'Autorità Europea per la Sicurezza Alimentare (EFSA) ha sviluppato negli ultimi anni un approccio strategico all'integrazione dell'intelligenza artificiale nei propri processi di valutazione scientifica, culminato nella pubblicazione dell'AI Roadmap Vision 2027 e in una serie di documenti tecnici che delineano best practices e principi operativi. Questo approccio si basa su standard metodologici rigorosi che bilanciano efficienza operativa e integrità scientifica, stabilendo un modello paradigmatico per l'implementazione responsabile dell'IA in contesti di valutazione del rischio alimentare e nutrizionale.

L'approccio EFSA all'IA si articola su tre pilastri concettuali e operativi interconnessi. Il primo pilastro riguarda lo sviluppo di ontologie semantiche avanzate e infrastrutture Big Data per la gestione strutturata dell'evidenza scientifica. EFSA ha investito significativamente nello sviluppo del FoodEx2 Exposure Hierarchy, un'ontologia complessa per la classificazione degli alimenti, e in sistemi di knowledge graph che permettono l'interrogazione semantica avanzata della letteratura scientifica. Questi sistemi consentono una catalogazione standardizzata delle evidenze, una ricerca più efficiente della letteratura pertinente e una valutazione più accurata della qualità metodologica degli studi scientifici.

Il secondo pilastro consiste nell'implementazione di framework di governance dell'IA che garantiscono validazione rigorosa e supervisione umana qualificata di tutti i processi automatizzati. EFSA ha stabilito che qualsiasi output generato da sistemi di IA deve essere sottoposto a validation against human gold standards prima di essere incorporato in valutazioni scientifiche ufficiali o utilizzato per supportare decisioni regolatorie. Questo approccio assicura che l'automazione non comprometta la qualità scientifica e che eventuali errori algoritmici vengano identificati e corretti prima che possano influenzare le decisioni di risk assessment.

Il terzo pilastro è rappresentato dal principio di human-centric AI, secondo cui l'intelligenza artificiale deve essere concepita come strumento di amplificazione delle capacità umane piuttosto che di sostituzione dell'expertise scientifica. Questo principio si traduce operativamente nella progettazione di sistemi di IA che supportano ma non sostituiscono gli esperti scientifici, fornendo strumenti di screening iniziale, sintesi automatizzata delle evidenze e identificazione di pattern nei dati, ma mantenendo sempre il controllo decisionale finale nelle mani di esperti qualificati.

Le implicazioni pratiche di questo approccio per le organizzazioni del settore privato sono significative. La ricerca scientifica automatizzata mediante IA, come nel caso di systematic reviews o meta-analisi assistite da algoritmi, deve mantenere validazione rigorosa contro standard umani comparabili con le metodologie tradizionali. I sistemi devono essere progettati per identificare e segnalare potenziali bias metodologici negli studi analizzati, utilizzando checklist validate come lo strumento GRADE (Grading of Recommendations, Assessment, Development and Evaluations). Infine, ogni output deve essere accompagnato da documentazione trasparente che specifichi quali processi sono stati automatizzati, quali validazioni umane sono state applicate, e quali sono i limiti metodologici e l'incertezza residua delle conclusioni.

ISO/IEC 42001:2023: Gestione Sistemica e Governata dei Sistemi di IA

Lo standard internazionale ISO/IEC 42001:2023 "Information technology — Artificial intelligence — Management system", pubblicato ufficialmente il 18 dicembre 2023 dall'International Organization for Standardization e dall'International Electrotechnical Commission, rappresenta il primo standard certificabile a livello mondiale per la gestione dei sistemi di intelligenza artificiale nelle organizzazioni. Questo framework normativo fornisce una struttura metodologica completa per implementare, mantenere e migliorare continuamente un sistema di gestione dell'IA (AI Management System, AIMS) che sia allineato con requisiti normativi, etici e operativi.

La struttura dello standard ISO/IEC 42001 segue il modello High-Level Structure (HLS) comune a tutti gli standard ISO per i sistemi di gestione, facilitando l'integrazione con altri standard come ISO 9001 (Quality Management), ISO 27001 (Information Security Management) e ISO/IEC 27701 (Privacy Information Management). Il framework si articola in dieci clausole principali che coprono l'intero ciclo di vita del sistema di gestione.

La Clausola 4 (Contesto dell'organizzazione) richiede alle organizzazioni di determinare le questioni esterne ed interne rilevanti per il sistema di gestione dell'IA, comprendendo l'analisi delle esigenze e aspettative delle parti interessate, l'identificazione dei requisiti legali e regolamentari applicabili (inclusi EU AI Act, GDPR, e normative settoriali specifiche), e la definizione dello scopo e confini del sistema di gestione dell'IA in relazione agli obiettivi strategici dell'organizzazione.

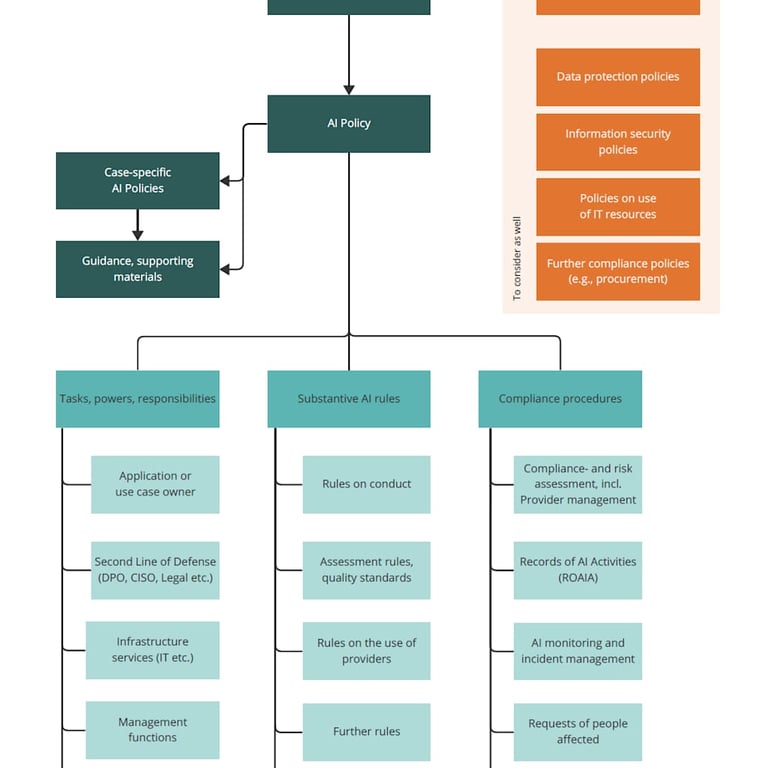

La Clausola 5 (Leadership) stabilisce i requisiti di governance, richiedendo l'impegno esplicito del top management, la definizione di una politica AI documentata che articoli i principi organizzativi per l'uso responsabile dell'IA, e l'assegnazione di ruoli, responsabilità e autorità chiare per tutti gli aspetti del sistema di gestione dell'IA. Questa clausola è particolarmente critica per garantire accountability organizzativa.

La Clausola 6 (Pianificazione) richiede un approccio sistematico alla valutazione dei rischi e delle opportunità associati all'IA, la definizione di obiettivi misurabili per il sistema di gestione dell'IA, e la pianificazione di azioni per raggiungere tali obiettivi. Nel contesto nutrizionale, questa pianificazione deve incorporare la valutazione specifica dei rischi per la salute umana, la sicurezza alimentare e l'accuratezza scientifica delle comunicazioni generate.

Le Clausole 7 e 8 (Supporto e Attività operative) dettagliano i requisiti per risorse umane competenti, infrastrutture tecnologiche adeguate, processi di gestione documentale, controlli operativi lungo tutto il ciclo di vita dei sistemi di IA (dalla progettazione al deployment al decommissioning), e gestione della supply chain per componenti AI sviluppate esternamente.

Le Clausole 9 e 10 (Valutazione delle prestazioni e Miglioramento) stabiliscono requisiti per monitoraggio continuo, audit interni, riesame della direzione, e gestione delle non-conformità attraverso azioni correttive e miglioramento continuo del sistema.

Per le organizzazioni del settore nutrizionale, l'implementazione di ISO/IEC 42001 fornisce un framework strutturato per allineare i sistemi di IA con i requisiti multipli e spesso complessi dell'EU AI Act, del GDPR (Regolamento UE 2016/679 sulla protezione dei dati personali), e delle normative settoriali specifiche come il Regolamento 1924/2006 e il Regolamento (UE) 2015/2283 sui novel foods.

Valutazione del Rischio e Classificazione dei Sistemi di IA nel Settore Nutrizionale

Metodologia di Risk Assessment Conforme all'EU AI Act

La valutazione accurata del livello di rischio di ciascun sistema di IA secondo la tassonomia dell'EU AI Act costituisce la fase fondamentale e imprescindibile di qualsiasi processo di implementazione conforme. Questa valutazione deve seguire una metodologia strutturata che consideri simultaneamente molteplici dimensioni: l'impatto potenziale sulla salute e sicurezza degli individui, il grado di automazione del processo decisionale, la sensibilità dei dati processati, il contesto d'uso del sistema, e le potenziali conseguenze di malfunzionamenti o decisioni errate.

Il processo di classificazione deve essere condotto attraverso un'analisi sistematica guidata da domande diagnostiche specifiche. In primo luogo, è necessario determinare se il sistema genera raccomandazioni o decisioni che impattano direttamente sulla salute o sicurezza umana. Nel contesto nutrizionale, questa domanda è particolarmente rilevante per sistemi che forniscono consulenza dietetica personalizzata, validano claims relativi a effetti sulla salute, o supportano decisioni terapeutiche nutrizionali. In secondo luogo, occorre valutare se il sistema influenza decisioni concernenti la conformità normativa, l'autorizzazione di prodotti alimentari, o la validazione di health claims, poiché tali decisioni hanno conseguenze regolatorie e commerciali significative. In terzo luogo, bisogna accertare se il sistema processa dati personali sensibili come definiti dall'Articolo 9 del GDPR, includendo dati sanitari, genetici, biometrici o relativi a condizioni di salute individuali. In quarto luogo, è necessario valutare se gli output del sistema potrebbero, in caso di errori o malfunzionamenti, costituire violazioni di diritti fondamentali, generare rischi per la sicurezza alimentare, o produrre informazioni ingannevoli per i consumatori. Infine, occorre determinare se il sistema integra dati provenienti da fonti esterne non controllate direttamente dall'organizzazione, introducendo potenziali vulnerabilità in termini di qualità, accuratezza e affidabilità dei dati.

Se la risposta a una o più di queste domande diagnostiche risulta affermativa, il sistema deve essere presumptivamente classificato come high-risk secondo l'Allegato III dell'EU AI Act, e conseguentemente soggetto a tutti gli obblighi stringenti stabiliti nel Titolo III, Capitolo 2 del Regolamento (Articoli 8-15), inclusi requisiti di quality management system, data governance, documentazione tecnica, record-keeping, trasparenza, human oversight, accuracy, robustness e cybersecurity.

Nel contesto specifico della comunicazione scientifica nutrizionale, diverse tipologie di sistemi ricadono tipicamente nella categoria high-risk con elevato grado di certezza. I sistemi di generazione di raccomandazioni nutrizionali personalizzate basate su profili individuali di salute, genetici o metabolici sono classificati high-risk per l'impatto diretto sulla salute umana e la necessità imprescindibile di human oversight qualificato. I sistemi di validazione automatizzata di health claims che verificano la conformità di dichiarazioni proposte rispetto al database EFSA autorizzato sono high-risk perché supportano decisioni normative con significative conseguenze commerciali e potenziale per generazione di misleading claims in caso di errore. I sistemi di analisi sistematica della letteratura scientifica utilizzati per identificare e sintetizzare prove a supporto di health claims submission a EFSA sono high-risk perché impattano direttamente sulle decisioni autorizzative con conseguenze di salute pubblica. I sistemi di fraud detection applicati alla documentazione tecnica nei dossier di autorizzazione sono high-risk per l'accesso a dati sensibili commerciali e l'impatto su processi di conformità normativa. Infine, i sistemi di quality control basati su computer vision per l'ispezione automatizzata di etichette alimentari e verifica della conformità delle dichiarazioni riportate sono high-risk per l'impatto diretto sulla sicurezza alimentare e sulla compliance delle informazioni fornite ai consumatori.

Requisiti di Conformità Operativa per i Sistemi High-Risk

Quality Management System: Struttura e Documentazione

L'Articolo 17 dell'EU AI Act stabilisce requisiti dettagliati per l'implementazione di un Quality Management System (QMS) robusto e documentato per tutti i provider di sistemi di IA ad alto rischio. Questo QMS deve essere proporzionato alle dimensioni dell'organizzazione ma comprensivo nei suoi elementi essenziali, coprendo l'intero ciclo di vita del sistema di IA dalla progettazione iniziale attraverso lo sviluppo, la validazione, il deployment, il monitoraggio post-market fino all'eventuale decommissioning.

Il QMS deve includere obbligatoriamente un sistema documentato di gestione del rischio conforme all'Articolo 9 del Regolamento, che prevede l'identificazione sistematica e la catalogazione di tutti i rischi ragionevolmente prevedibili associati all'uso previsto e all'uso ragionevolmente prevedibile ma improprio del sistema. Questa identificazione deve considerare rischi per la salute e sicurezza, rischi per i diritti fondamentali (inclusi privacy, non-discriminazione, equità), e rischi operativi. Per ciascun rischio identificato, il QMS deve documentare la valutazione quantitativa o qualitativa della probabilità di occorrenza e della severità potenziale delle conseguenze, utilizzando metodologie validate come la matrice di rischio ISO 31000 o analisi FMEA (Failure Mode and Effects Analysis). Devono inoltre essere documentate le misure di mitigazione implementate per ridurre i rischi a livelli accettabili, le validazioni dell'efficacia di tali misure, e i rischi residui che permangono dopo l'implementazione delle mitigazioni.

Il QMS deve stabilire e documentare procedure rigorose per la raccolta, l'elaborazione e la validazione dei dati utilizzati per training, validation e testing dei sistemi di IA, come richiesto dall'Articolo 10 del Regolamento. Queste procedure devono garantire che i dataset siano rilevanti, rappresentativi, privi di errori significativi, e completi rispetto alle caratteristiche della popolazione target. Nel contesto nutrizionale, ciò implica garantire che i dati includano adeguata rappresentanza di diverse popolazioni geografiche, gruppi etnici, fasce d'età, condizioni di salute, e pattern dietetici, per evitare bias sistematici che potrebbero portare a raccomandazioni inadeguate per sottopopolazioni specifiche.

La documentazione tecnica richiesta dall'Articolo 11 e dettagliata nell'Allegato IV del Regolamento deve fornire una descrizione comprensiva del sistema, includendo: architettura complessiva e componenti principali; algoritmi e tecniche di machine learning utilizzati; dataset di training, validation e testing con dettagli su composizione, sorgenti, metodologie di raccolta e preprocessing; metriche di performance e risultati di validation; limitazioni note del sistema e condizioni operative per cui il sistema è stato validato; analisi dei rischi e misure di mitigazione; procedimenti di human oversight implementati; misure di cybersecurity e protezione dei dati.

Il sistema di record-keeping e logging richiesto dall'Articolo 12 deve garantire la tracciabilità automatica di tutte le decisioni del sistema attraverso la registrazione temporalmente marcata di tutti gli input ricevuti, tutti gli output generati, tutte le decisioni algoritmiche intermedie rilevanti, tutti gli interventi umani di override o validazione, e tutti gli eventi anomali o malfunzionamenti identificati.

Trasparenza, Informazione agli Utenti e AI Nutrition Labels

L'Articolo 13 dell'EU AI Act impone obblighi stringenti di trasparenza per i sistemi ad alto rischio, richiedendo che i deployer forniscano informazioni chiare, comprensibili e accessibili agli individui che interagiscono con il sistema o sono soggetti alle sue decisioni. Nel contesto della comunicazione scientifica nutrizionale, questi obblighi si traducono in requisiti specifici per l'informazione di consumatori, professionisti sanitari e autorità regolatorie.

Le informazioni fornite devono essere accessibili e comprensibili a diverse audience senza necessità di background tecnico specialistico, utilizzando linguaggio chiaro, non ambiguo e appropriato al livello di comprensione atteso dell'utilizzatore. Deve essere comunicato esplicitamente e in modo prominente che le informazioni, raccomandazioni o decisioni sono generate o supportate da un sistema di intelligenza artificiale, distinguendo chiaramente tra valutazioni puramente algoritmiche e valutazioni validate da esperti umani. I consumatori e le autorità devono avere la possibilità di comprendere, a un livello appropriato di dettaglio, come il sistema è giunto a una specifica conclusione o raccomandazione, quali dati sono stati considerati, e quale logica decisionale è stata applicata. Infine, l'informazione deve esplicitare chiaramente le capacità e i limiti del sistema, evitando claim esagerati sulle sue performance e specificando le condizioni operative per cui il sistema è stato validato.

Un approccio pratico per soddisfare questi requisiti di trasparenza nel settore nutrizionale è rappresentato dall'implementazione di "AI Nutrition Labels" o "Model Cards", concettualmente analoghe alle etichette nutrizionali presenti sui prodotti alimentari. Questi strumenti di disclosure strutturata dovrebbero documentare in formato standardizzato e facilmente accessibile: la provenienza e qualità dei dati utilizzati dal sistema (ad esempio "letteratura peer-reviewed indicizzata in PubMed e database EFSA"), specificando le date di copertura temporale e le metodologie di quality assurance applicate; le metodologie algoritmiche utilizzate in termini non-tecnici (ad esempio "comparazione semantica automatizzata di ingredienti proposti contro liste EFSA di sostanze autorizzate, con soglie di matching definite"); le misure di bias mitigation implementate, specificando quali popolazioni e condizioni sono state incluse nel testing di fairness (ad esempio "sistema testato per equità di performance su 15 gruppi demografici diversi per età, genere ed etnia"); l'approccio di validazione utilizzato e le metriche di performance ottenute (ad esempio "95% di agreement con valutazioni di esperti umani qualificati su dataset di test di 1000 casi"); la natura e il momento dell'oversight umano nel processo (ad esempio "ogni health claim generato è revisionato da nutrizionista qualificato EFSA prima della pubblicazione"); le limitazioni esplicite del sistema e gli usi inappropriati da evitare (ad esempio "il sistema non fornisce consulenza medica per condizioni patologiche diagnosticate e non sostituisce la valutazione di professionisti sanitari qualificati").

Human Oversight: Modelli Implementativi e Best Practices

L'Articolo 14 dell'EU AI Act stabilisce che i sistemi di IA ad alto rischio devono essere progettati e sviluppati in modo tale da permettere una supervisione umana effettiva durante il loro utilizzo. Questo requisito fondamentale si basa sul principio che decisioni con impatto significativo sulla vita delle persone non possono essere delegate interamente a sistemi automatizzati senza possibilità di intervento, controllo e override da parte di esseri umani competenti e responsabili.

Il Regolamento identifica tre modalità principali di human oversight, ciascuna appropriata per diversi contesti d'uso e livelli di rischio. Il modello Human-in-the-Loop (HITL) prevede che il sistema generi raccomandazioni o proposte decisionali che devono essere esplicitamente approvate da un operatore umano competente prima dell'esecuzione o della comunicazione ai destinatari finali. Questo modello è appropriato per decisioni con impatto elevato sulla salute o sicurezza, come la validazione di health claims prima della pubblicazione, la generazione di raccomandazioni nutrizionali terapeutiche personalizzate, o l'approvazione di modifiche a formulazioni di prodotti alimentari. L'implementazione efficace di HITL richiede la progettazione di interfacce utente che presentino chiaramente le raccomandazioni del sistema insieme alle informazioni rilevanti per la valutazione (evidenze scientifiche di supporto, livello di confidenza, fattori considerati), richiedano un'azione esplicita di approvazione o rigetto, e registrino la decisione umana con motivazioni quando pertinente. Il personale che esercita la supervisione HITL deve possedere competenze specifiche nel dominio di applicazione (ad esempio dietisti, nutrizionisti o food scientists qualificati) e ricevere training adeguato sulle capacità e limitazioni del sistema di IA.

Il modello Human-on-the-Loop (HOTL) prevede una supervisione umana con capacità di intervento in qualsiasi momento, ma il sistema opera autonomamente entro parametri predefiniti e sotto monitoraggio continuo. Questo modello è appropriato per sistemi con impatto medio dove l'automazione completa fornisce benefici di efficienza significativi ma rimane necessaria la possibilità di intervento umano per casi anomali o situazioni non previste. Un esempio applicativo nel settore nutrizionale è lo screening automatizzato di documentazione tecnica per completezza e conformità formale, con alert agli operatori umani quando vengono identificate anomalie che richiedono investigazione approfondita. L'implementazione di HOTL richiede dashboard di monitoraggio che visualizzino in tempo reale le attività del sistema, le decisioni prese, e gli indicatori di performance, con meccanismi di alert automatici per situazioni che richiedono attenzione umana (ad esempio anomalie statistiche, casi con bassa confidenza del sistema, o decisioni borderline).

Il modello Human-in-Command (HIC) mantiene il controllo strategico e tattico completo nelle mani di operatori umani, con l'IA che fornisce supporto decisionale ma non autonomia operativa. Questo modello è appropriato per decisioni critiche che impattano sulla conformità normativa fondamentale, sulla sicurezza alimentare o su diritti fondamentali, come l'approvazione finale di submission di health claims a EFSA, decisioni di recall di prodotti, o modifiche significative a processi di produzione con implicazioni di sicurezza. L'implementazione richiede workflow in cui l'IA fornisce analisi, sintesi e raccomandazioni che informano ma non vincolano la decisione umana finale, con tracciabilità completa del processo decisionale umano e delle sue motivazioni.

Per i sistemi di comunicazione nutrizionale, il modello HITL è generalmente richiesto e considerato best practice per qualsiasi processo che genera health claims, raccomandazioni nutrizionali con potenziale impatto sulla salute, o informazioni destinate a guidare scelte alimentari con rilevanza sanitaria. La transizione verso modelli HOTL o HIC dovrebbe essere considerata solo dopo dimostrazione robusta della reliability del sistema attraverso periodi estesi di operation sotto supervisione HITL, con documentazione completa delle performance e assenza di errori critici.

Post-Market Monitoring e Continuous Compliance

L'Articolo 72 dell'EU AI Act introduce l'obbligo di post-market monitoring per i provider di sistemi ad alto rischio, richiedendo la messa in atto di sistemi per la raccolta attiva e sistematica di informazioni sull'esperienza acquisita dall'uso dei sistemi di IA dopo la loro immissione sul mercato o messa in servizio, per identificare tempestivamente rischi emergenti e esigenze di azioni correttive.

Il sistema di post-market monitoring deve essere proporzionato alla natura del sistema di IA e ai rischi da esso posti, ma deve obbligatoriamente includere diversi componenti funzionali. In primo luogo, un sistema di data collection che traccia sistematicamente le interazioni tra sistema e utenti, registrando tipologia e frequenza delle richieste, pattern di utilizzo, contesti operativi reali (che potrebbero differire da quelli previsti inizialmente), e feedback esplicito degli utilizzatori. In secondo luogo, un sistema di performance evaluation che verifica continuamente che il sistema mantiene nel deployment reale gli standard di accuracy, precision, recall e altri KPI stabiliti durante la validation, con particolare attenzione all'identificazione di performance degradation nel tempo o per specific use cases. In terzo luogo, un sistema di incident reporting conforme all'Articolo 73 del Regolamento, che documenta tutti i malfunzionamenti, gli errori significativi, le situazioni anomale, e le violazioni dei requisiti di sicurezza o compliance, con procedure per la notifica tempestiva alle autorità competenti quando richiesto. In quarto luogo, processi di audit ciclico con frequenza appropriata al livello di rischio (ad esempio annualmente per sistemi high-risk nella comunicazione nutrizionale) per valutare la conformità continuativa a tutti i requisiti applicabili. Infine, procedure di change management documentate che assicurano che qualsiasi aggiornamento al sistema (inclusi retraining di modelli, modifiche a algoritmi, o estensione delle funzionalità) sia soggetto a risk assessment, validation e approval formale prima del deployment.

I deployer di sistemi ad alto rischio devono essere preparati a dimostrare, su richiesta delle autorità di sorveglianza del mercato, la conformità continua durante tutta l'operazione del sistema attraverso documentazione completa e verificabile dei processi di monitoring e dei risultati ottenuti. Questa documentazione deve essere mantenuta per un periodo di almeno 10 anni dalla data di immissione sul mercato del sistema, come richiesto dall'Articolo 18 del Regolamento.

Integrazione con Framework EFSA e Regulation 1924/2006: Compliance Operativa

Alignment della Comunicazione Generata dall'IA con Database EFSA

Un requisito cruciale per la conformità dei sistemi di IA nel settore nutrizionale è che qualsiasi comunicazione sulle proprietà salutistiche degli alimenti generata o supportata dall'IA deve essere completamente allineata con i database ufficiali e le linee guida scientifiche EFSA. Questo alignment richiede l'implementazione di meccanismi tecnici e processi organizzativi specifici.

In primo luogo, i sistemi devono integrare un modulo di automatic cross-referencing che verifica in tempo reale rispetto al Registro UE delle indicazioni nutrizionali e sulla salute, mantenuto dalla Commissione Europea e accessibile pubblicamente. Questo registro contiene tutte le health claims autorizzate con le loro formulazioni esatte, le condizioni d'uso, le eventuali restrizioni, e le popolazioni target. Il sistema di IA deve verificare che qualsiasi health claim proposto o generato corrisponda esattamente a un'entrata autorizzata nel registro, con matching non solo sul contenuto semantico ma anche sulla formulazione letterale esatta, poiché variazioni anche minori potrebbero alterare il significato scientifico o essere considerate non conformi dalle autorità.

In secondo luogo, i sistemi devono verificare che gli elementi nutrizionali referenziati (vitamine, minerali, altre sostanze) e le loro quantità siano basati sui Dietary Reference Values (DRV) stabiliti da EFSA e pubblicati in una serie di Scientific Opinions del Panel NDA tra il 2015 e il 2017. Questi DRV rappresentano i valori di riferimento per l'assunzione di nutrienti nella popolazione europea e costituiscono la base per qualsiasi claim relativo a contribuzione al soddisfacimento di fabbisogni nutrizionali.

In terzo luogo, per prodotti contenenti novel foods o novel food ingredients, i sistemi devono verificare l'autorizzazione nella Union List of Novel Foods stabilita e aggiornata periodicamente in conformità al Regolamento (UE) 2015/2283. Solo ingredienti presenti in questa lista o utilizzati significativamente nell'UE prima del 15 maggio 1997 possono essere commercializzati, e qualsiasi comunicazione su tali ingredienti deve rispettare le condizioni d'uso specificate nell'autorizzazione.

Infine, i sistemi devono verificare la conformità con i requisiti generali di composition and labeling stabiliti nel Regolamento (UE) n. 1169/2011 relativo alla fornitura di informazioni sugli alimenti ai consumatori, assicurando che le informazioni generate siano accurate, non ingannevoli, verificabili, e presentate in modo comprensibile per i consumatori.

L'implementazione tecnica di questi meccanismi di cross-referencing richiede l'integrazione di database strutturati regolarmente aggiornati (le liste EFSA e della Commissione vengono aggiornate periodicamente con nuove autorizzazioni), algoritmi di matching semantico avanzato capaci di gestire variazioni linguistiche e sinonimi pur mantenendo fedeltà alle formulazioni autorizzate, e sistemi di alert che notifichino gli operatori quando vengono identificate potenziali non-conformità che richiedono review umana approfondita.

Scientificità e Riproducibilità delle Valutazioni Assistite da IA

Quando i sistemi di IA vengono utilizzati per supportare la valutazione della substantiation scientifica di health claims, come nel caso di AI-assisted systematic reviews della letteratura scientifica, devono essere implementati controlli stringenti per garantire che gli standard di rigore metodologico e riproducibilità siano equivalenti o superiori a quelli delle valutazioni condotte manualmente da esperti umani.

Le linee guida EFSA per la substantiation scientifica delle health claims, pubblicate nel 2011 e aggiornate nel 2016 con specifico focus sui requisiti per studi clinici, stabiliscono criteri metodologici rigorosi che qualsiasi evidenza scientifica deve soddisfare per essere considerata appropriata a supportare una health claim. Questi criteri comprendono una gerarchia di evidenza in cui studi su popolazione umana (in particolare randomized controlled trials) sono prioritari rispetto a studi in vitro o su modelli animali. Viene inoltre richiesta una valutazione rigorosa della qualità metodologica di ciascuno studio considerato, utilizzando strumenti standardizzati per l'assessment del risk of bias come lo strumento Cochrane Risk of Bias tool per RCT o ROBINS-I per studi osservazionali. È necessaria una valutazione della coerenza complessiva dell'evidenza scientifica nel supportare la relazione causa-effetto tra consumo della sostanza e l'effetto salutistico dichiarato, considerando la consistenza dei risultati tra studi diversi, la dose-response relationship, e la plausibilità biologica basata sulla conoscenza dei meccanismi d'azione.

I sistemi di IA utilizzati per condurre systematic reviews devono essere validati contro gold standard umani per garantire che non introducono bias sistematici nella identificazione degli studi rilevanti (ad esempio tramite search strategies incomplete o query mal formulate), nella selezione degli studi da includere (evitando sia falsi positivi che falsi negativi rispetto ai criteri di inclusione/esclusione), nella estrazione dei dati dagli studi (garantendo accuracy completa delle informazioni estratte), nella valutazione della qualità metodologica (applicando correttamente gli strumenti standardizzati di risk of bias assessment), o nella sintesi delle evidenze (evitando conclusioni non supportate dalla totalità delle prove).

La validazione deve includere comparison con systematic reviews condotte manualmente da esperti seguendo standard metodologici riconosciuti come quelli Cochrane, con metriche quantitative di agreement (ad esempio kappa statistics per inter-rater reliability), e documentazione trasparente di qualsiasi discrepanza identificata con analisi delle cause root. Solo dopo dimostrazione robusta di equivalenza o superiorità rispetto agli standard umani i sistemi IA possono essere considerati affidabili per utilizzo in contesti regolatori.

Implementazione Pratica: Roadmap Operativa per le Organizzazioni

Fase 1: Assessment Iniziale e Gap Analysis (Mesi 0-3)

La fase iniziale di assessment costituisce la fondazione essenziale per qualsiasi progetto di implementazione conforme di sistemi di IA nella comunicazione scientifica nutrizionale. Questa fase deve essere condotta con rigore metodologico e coinvolgimento cross-funzionale di competenze diverse per garantire una comprensione completa dello stato attuale e dei requisiti normativi applicabili.

La prima attività critica è la creazione di un AI System Inventory esaustivo che mappi tutti i sistemi di intelligenza artificiale attualmente in uso nell'organizzazione o pianificati per deployment futuro. Questo inventario deve documentare per ciascun sistema: la descrizione funzionale e lo scopo d'uso; le tecnologie e algoritmi utilizzati; i dati processati (tipologia, sensibilità, volumi); gli utilizzatori e i destinatari degli output; il contesto operativo e l'ambiente di deployment; la criticità per i processi aziendali e l'impatto potenziale su stakeholder esterni. Particolare attenzione deve essere dedicata all'identificazione di sistemi che potrebbero non essere immediatamente riconosciuti come "AI" dall'organizzazione ma che tecnicamente ricadono nella definizione dell'Articolo 3 dell'EU AI Act, come sistemi di recommendation engines, rule-based expert systems, o analytics tools avanzati.

La seconda attività è la Risk Classification di ciascun sistema identificato secondo la tassonomia dell'EU AI Act. Questa classificazione deve applicare la metodologia di risk assessment descritta precedentemente, determinando per ogni sistema se ricade nelle categorie unacceptable risk, high-risk, limited risk o minimal risk. Per i sistemi high-risk, deve essere condotta un'analisi dettagliata dei requisiti specifici applicabili in base all'Allegato III del Regolamento e alle caratteristiche del sistema.

La terza attività è la Gap Analysis che confronta lo stato attuale di ciascun sistema high-risk con i requisiti normativi applicabili, identificando discrepanze e aree di non-conformità. Questa analisi deve considerare tutti gli aspetti del framework normativo: qualità e governance dei dati, documentazione tecnica, trasparenza e informazione agli utenti, human oversight, accuracy e robustness, cybersecurity, post-market monitoring, e conformity assessment. Per ciascuna gap identificata, deve essere valutata la severità (critica, alta, media, bassa) basata sul rischio di non-conformità e le potenziali conseguenze.

La quarta attività è lo Stakeholder Mapping che identifica tutti i team interni che devono essere coinvolti nel progetto di compliance (tipicamente Legal/Compliance, IT/Data Science, Quality Assurance, Scientific Affairs, e Business Units proprietarie dei sistemi) e definisce ruoli, responsabilità e modalità di collaborazione.

L'output di questa fase è un Assessment Report comprensivo che documenta l'inventario completo dei sistemi, la classificazione di rischio, le gap identificate con prioritizzazione, e un piano di alto livello per le fasi successive. Questo documento fornisce la base informativa per decisioni di investimento e planning del progetto di compliance.

Fase 2-5: Governance, Technical Implementation, Validation, Deployment

Le fasi successive del processo di implementazione seguono una progressione logica dall'establishment della governance organizzativa, attraverso l'implementazione tecnica dei controlli e delle capabilities necessarie, alla validation completa dei sistemi, fino al deployment operativo con monitoring continuo. Per ragioni di brevità, queste fasi sono qui sintetizzate nei loro elementi essenziali, rimandando alla documentazione tecnica citata nelle referenze per dettagli implementativi.

La Fase 2 di Governance Setup stabilisce le strutture organizzative e i framework di policy necessari, includendo la costituzione di un AI Governance Committee con rappresentanza cross-funzionale, lo sviluppo di una AI Policy che articola principi e requisiti, l'implementazione di un Data Governance Framework con ruoli RACI chiari, e la definizione di Risk Assessment Protocols standardizzati.

La Fase 3 di Technical Implementation realizza le capabilities tecniche necessarie per la conformità dei sistemi high-risk, implementando Quality Management Systems documentati, Data Validation Pipelines automatizzate, interfacce per Human Oversight efficace, sistemi di Audit Trail Logging comprensivi, e dashboard per Performance Monitoring continuo.

La Fase 4 di Validation and Testing verifica la conformità e l'adeguatezza dei sistemi attraverso Scientific Validation contro gold standards, Bias Testing su diverse popolazioni, Scenario Testing per edge cases e failure modes, consultazione con autorità regolatorie competenti, e Pilot Deployment con monitoring intensivo.

La Fase 5 di Deployment and Post-Market Monitoring stabilisce le operazioni a regime con Full Deployment dei sistemi validati, User Training per tutto il personale coinvolto, Incident Management procedures operative, cicli di Continuous Improvement basati su feedback e monitoring, e mantenimento di Regulatory Documentation aggiornata per inspection da parte delle autorità.

Conclusioni: Verso un Futuro di AI Nutrizionale Responsabile e Trustworthy

L'implementazione dell'intelligenza artificiale nella comunicazione scientifica nutrizionale rappresenta non una dicotomia tra innovazione tecnologica e conformità normativa, ma piuttosto un'opportunità strategica di combinare il potenziale trasformativo dell'IA con i più elevati standard di integrità scientifica, protezione dei consumatori e accountability istituzionale. Le organizzazioni che navigano con successo questo landscape complesso — quelle che implementano l'IA in modo genuinamente responsabile, trasparente e well-governed — non solo evitano rischi regolatori e reputazionali, ma acquisiscono un vantaggio competitivo sostenibile basato sulla trust degli stakeholder, elemento sempre più differenziante in un mercato caratterizzato da crescente scetticismo verso le tecnologie digitali e richiesta di trasparenza.

Il framework normativo europeo, pur complesso e talvolta oneroso, fornisce alle organizzazioni una roadmap chiara per l'implementazione responsabile. L'EU AI Act, il Regolamento 1924/2006, le linee guida EFSA, e lo standard ISO/IEC 42001 formano un ecosistema normativo coerente che, se adeguatamente compreso e implementato, permette di coniugare innovazione e compliance, efficienza operativa e rigore scientifico, automazione e oversight umano.

Per il settore della nutrizione e del benessere, l'era dell'IA responsabile non costituisce una minaccia alla competitività ma un'opportunità per servire meglio i consumatori attraverso raccomandazioni più accurate e personalizzate, per accelerare l'innovazione attraverso processi di R&D più efficienti, e per costruire fiducia duratura attraverso trasparenza e accountability. Le organizzazioni che abbracciano proattivamente questa sfida, investendo nelle competenze, nei processi e nelle tecnologie necessarie per la compliance, saranno posizionate come leader trusted del settore nei decenni a venire.

#NutriAI #NutriAINewsletter #IntelligenzaArtificiale #AI #Nutrizione #ComunicazioneScientifica #FoodTech #SicurezzaAlimentare #RegolamentoAI #EFSA #ConformitàNormativa #ISO42001 #HealthClaims #InnovazioneDigitale #AIResponsabile #TrasparenzaAI #Governance #DataScience #NutriAI #ComplianceAlimentare #NutrizioneDigitale #FoodLaw #RischioAltoAI #TrustInAI

Disclaimer: Tutti i diritti delle immagini e contenuti utilizzati appartengono ai rispettivi proprietari. Questo articolo è fornito a scopo educativo e informativo. Non costituisce consulenza legale o normativa. Le organizzazioni dovrebbero consultare esperti legali e normativi qualificati prima di implementare sistemi di IA nel settore nutrizionale.

--------------------------------------------------------------------------

Riferimenti Bibliografici e Normativi

European Union. (2024). Regulation (EU) 2024/1689 of the European Parliament and of the Council of 13 June 2024 laying down harmonised rules on artificial intelligence and amending Regulations (EC) No 300/2008, (EU) No 167/2013, (EU) No 168/2013, (EU) 2018/858, (EU) 2018/1139 and (EU) 2019/2144 and Directives 2014/90/EU, (EU) 2016/797 and (EU) 2020/1828 (Artificial Intelligence Act). Official Journal of the European Union, L 1689/1, 12 July 2024.

European Commission. (2006). Regulation (EC) No 1924/2006 of the European Parliament and of the Council of 20 December 2006 on nutrition and health claims made on foods. Official Journal of the European Union, L 404/9, 30 December 2006. Consolidated version available at: https://eur-lex.europa.eu/legal-content/EN/TXT/?uri=CELEX:02006R1924-20141213

European Food Safety Authority (EFSA). (2024). AI@EFSA: Artificial Intelligence at EFSA. EFSA Corporate Publications. Available at: https://www.efsa.europa.eu/en/corporate-pubs/aiefsa

European Food Safety Authority (EFSA) (2024). Ontology roadmapping and case study implementation. EFSA Journal, 22(11):e221201. doi: 10.2903/j.efsa.2024.e221201

European Food Safety Authority (EFSA), (2022). Roadmap for action on Artificial Intelligence (AI) for evidence management in risk assessment: from the project More Knowledge for Better Food (KNOW4Food). EFSA Supporting Publications, 19(5):EN-7339. doi: 10.2903/sp.efsa.2022.EN-7339

European Food Safety Authority (EFSA) NDA Panel. (2017). General scientific guidance for stakeholders on health claim applications. EFSA Journal, 15(1):4680. doi: 10.2903/j.efsa.2017.4680. Available at: https://www.efsa.europa.eu/en/efsajournal/pub/4680

European Food Safety Authority (EFSA). (2025). Symposium on Data Readiness for Artificial Intelligence. EFSA Supporting Publications, EN-9434. doi: 10.2903/sp.efsa.2025.EN-9434

International Organization for Standardization (ISO) and International Electrotechnical Commission (IEC). (2023). ISO/IEC 42001:2023 Information technology — Artificial intelligence — Management system. ISO/IEC JTC 1/SC 42. First edition 2023-12-18. Available at: https://www.iso.org/standard/81230.html

European Union. (2016). Regulation (EU) 2016/679 of the European Parliament and of the Council of 27 April 2016 on the protection of natural persons with regard to the processing of personal data and on the free movement of such data (General Data Protection Regulation). Official Journal of the European Union, L 119/1, 4 May 2016.

European Union. (2015). Regulation (EU) 2015/2283 of the European Parliament and of the Council of 25 November 2015 on novel foods. Official Journal of the European Union, L 327/1, 11 December 2015.

European Union. (2011). Regulation (EU) No 1169/2011 of the European Parliament and of the Council of 25 October 2011 on the provision of food information to consumers. Official Journal of the European Union, L 304/18, 22 November 2011.

Federation of European Risk Management Associations (FERMA). (2024). EU Policy Note on the Artificial Intelligence Act: Risk Management Implications. Brussels: FERMA. Available at: https://www.ferma.eu/publications/

AZTI Technology Centre. (2025). Ethics in Artificial Intelligence for Food and Health: Guidelines for Responsible Implementation. San Sebastián: AZTI. Available at: https://www.azti.es/en/ethics-in-artificial-intelligence-for-food-and-health/

European Commission. (2024). EU Register on nutrition and health claims. Available at: https://ec.europa.eu/food/safety/labelling_nutrition/claims/register/public/

Contatti

Seguimi su LinkedIn

Nutri-AI 2025 - Alessandro Drago. Tutti i diritti sono riservati

e-mail: info@nutri-ai.net